1. 신경망

뉴런과 뉴런 사이에는 시냅스라는 연결 부위가 존재

신경 말단에서 자극을 받으면 시냅스에서 화학 물질이 나와 전위 변화를 일으킴

전위가 임계 값을 넘으면 다음 뉴런에 신호를 보내고, 넘지 않으면 아무 동작도 하지 않음

→ 로지스틱 회귀의 원리와 유사

뉴런과 비슷한 메커니즘을 사용하여 인공적으로 생각하는 무언가를 만드는 것, '인공 신경망(Artificial Neural Network)'

2. 퍼셉트론(perceptron)

- 신경망을 이루는 가장 중요한 기본 단위

- 입력 값과 활성화 함수를 사용해 출력 값을 다음으로 넘기는 가장 작은 신경망 단위

1) 가중치, 가중합, 바이어스, 활성화 함수

- 딥러닝 용어로 표현해보면

- y=ax+b → y=wx+b

- 기울기 a → 가중치 w(weight)

- y절편 b → 편향 b(bias)

- 가중합(weighted sum) = x와 w의 곱을 모두 더한 다음 b를 더한 값

- 활성화 함수(activation function): 가중합의 결과를 놓고 1 또는 0을 판단하는 함수

- ex) 시그모이드 함수

2) 퍼셉트론의 과제

하나의 퍼셉트론 만으로는 많은 것을 기대 X

- 한계

- 2차원 상에서 해결할 수 없는 상황

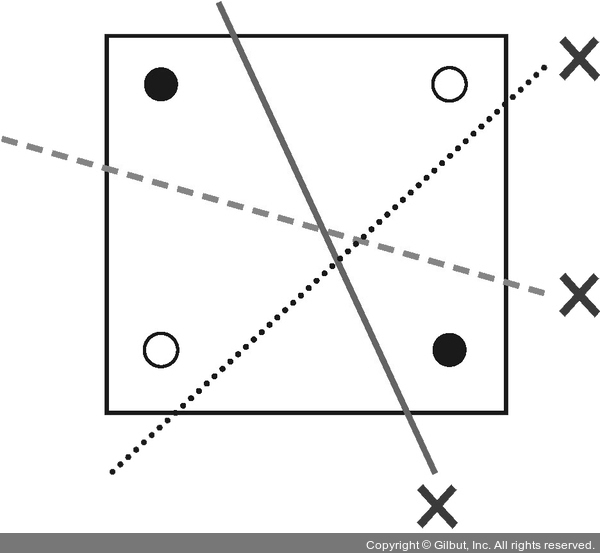

- ex) 직선의 한쪽 편에는 검은 점만 있고, 다른 한쪽에는 흰 점만 있게끔 선을 그어라

3) XOR 문제

- 퍼셉트론의 한계를 설명할 때 등장하는 대표적인 문제

AND와 OR의 경우 직선을 그어 검은색 점을 구별할 수 있다.

그러나 XOR의 경우 불가능

→ 10여 년이 지난 후, 다층 퍼셉트론(multilayer perceptron) 개념의 등장으로 해결

'ML > 모두의 딥러닝' 카테고리의 다른 글

| 8장) 오차 역전파 (0) | 2023.07.10 |

|---|---|

| 7장) 다층 퍼셉트론 (0) | 2023.07.10 |

| 5장) 참 거짓 판단 장치 : 로지스틱 회귀 (0) | 2023.07.10 |

| 4-2장) 다중 선형 회귀 (0) | 2023.07.07 |

| 4-1장) 오차 수정하기 : 경사 하강법 (0) | 2023.07.06 |